Vision AI

Description

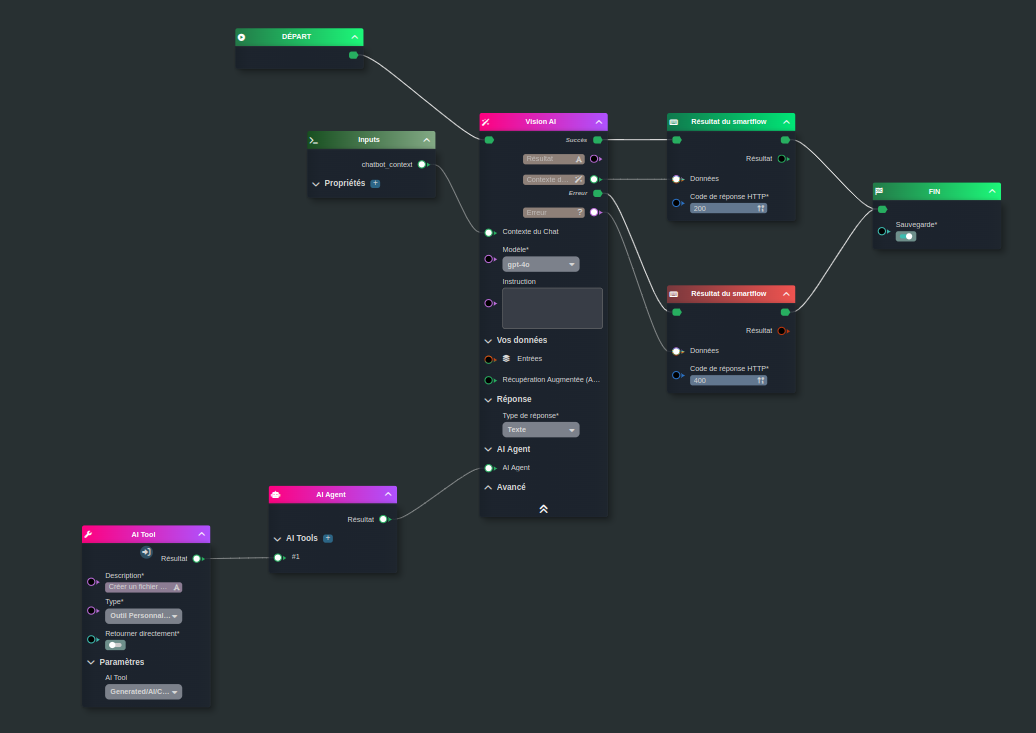

La tâche Vision AI permet d’interagir avec un LLM.

Cette tâche gère plusieurs fonctionnalités :

- **RAG** : Enrichissement des réponses à partir de documents indexés.

- **Agent / Tool** : Entité autonome capable de prendre des décisions, d'exécuter des actions et d'interagir avec son environnement en utilisant des outils entièrement configurables en NoCode.

- **Format de réponse**: Texte, JSON ou SmartObject.

Fonctionnement

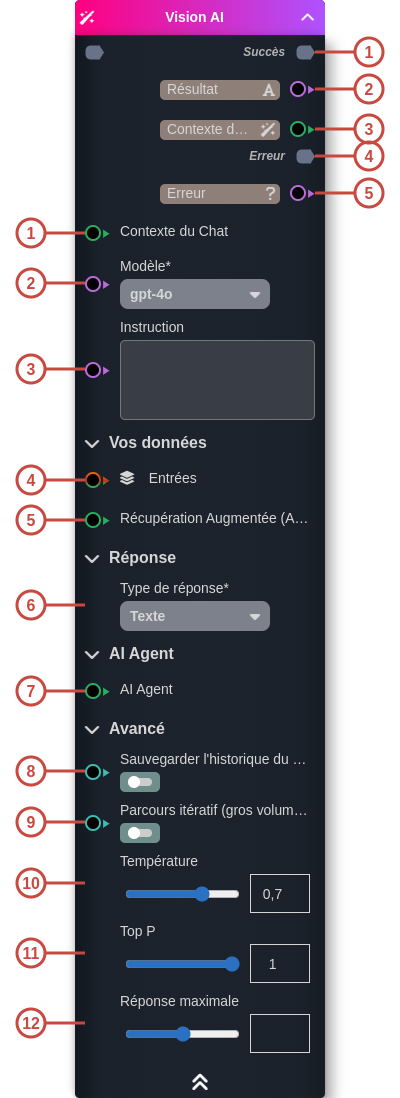

Entrées

| ID | Nom | Type | Description |

|---|---|---|---|

| 1 | Contexte du Chat | sys:ai_context | Le contexte du chat, issu du widget ChatBot, permet d’injecter le prompt, l’historique ou d’autres éléments contextuels. |

| 2 | Modèle | string | Choix du LLM à utiliser (par ex. : gpt-3.5-turbo, gpt-4o…). |

| 3 | Instruction | string | Permet de transmettre des instructions au LLM : - Si le Contexte du Chat est précisé (via un ChatBot), cela définit les instructions système. - Si le Contexte du Chat n’est pas précisé, cela définit directement à la demande utilisateur. |

| 4 | Entrées | so:*, obejct, sys:file | Permet de transmettre des informations supplementaire au LLM: SmartObjects, Objets ou Fichiers (PDF, DOCX, etc.). Attention : la taille des entrées ne doit pas dépasser 4000 tokens. Sinon, les documents seront indexés automatiquement et seuls les extraits les plus pertinents seront traités. Pour des traitements en masse, il est recommandé de découper les données en amont et d'ittérer. |

| 5 | Récupération Augmentée (AI index) | sys:ai_retriever | Active la RAG et définit comment les paquets de documents pertinents sont recherchés et injectés dans le LLM |

| 6 | Type de réponse | string | Définit le type de réponse attendu : - Texte : renvoie uniquement du texte. - JSON : renvoie un objet JSON, avec un exemple de structure précisé pour définir le format attendu. - SmartObject : renvoie un SmartObject (en précisant le modèle, la stratégie et la configuration de sauvegarde via l’API). |

| 7 | AI Agent | sys:ai_agent | Permet de créer un agent et de lui associer des outils spécifiques. |

| 8 | Sauvegarder l'historique du chat | boolean | Active la sauvegarde de l’historique du chat. Lorsque cette option est activée, le contexte est stocké en base de données, et un chatId est renvoyé dans le résultat pour une réutilisation future. Remarque : lors de l’utilisation de la tâche avec des agents, il est fortement recommandé d’activer cette option pour conserver l’état du graphe et l’ensemble des outils utilisés. |

| 9 | Parcours itératif (gros volume de données) | boolean | Permet de traiter de gros volumes de données en dépassant les limites du modèle grâce à des appels multiples vers le LLM, après découpage préalable des données. |

| 10 | Température | number | Contrôle le caractère aléatoire : - Une température basse produit des réponses plus répétitives et déterministes. - Une température élevée entraîne des réponses plus inattendues ou créatives. Il est conseillé de régler soit la température, soit Top P, mais pas les deux simultanément. |

| 11 | Top P | number | Contrôle également le caractère aléatoire, mais via une autre méthode : - Un Top P bas restreint la sélection aux tokens les plus probables. - Un Top P élevé permet de choisir parmi des tokens à probabilité plus faible. Il est conseillé de régler soit la température, soit Top P, mais pas les deux simultanément. |

| 12 | Réponse maximale | number | Définit une limite sur le nombre de tokens par réponse générée par le modèle. Le nombre total de tokens inclut l’invite (message système, exemples, historique des messages et requête utilisateur) ainsi que la réponse du modèle. Note : un token correspond à environ 4 caractères pour un texte anglais typique. |

Sorties

| ID | Nom | Type | Description |

|---|---|---|---|

| 1 | Succès | flow | Flux de sortie lorsque l'appel LLM se termine sans erreur |

| 2 | string, so:*, object | Résultat de la tâche au format défini par le paramètre Type de réponse. | |

| 3 | sys:ai_context | Contexte du Chat : contient la réponse, l’historique et d’autres informations pour l'utilisation avec le widget ChatBot. | |

| 4 | Erreur | flow | Flux de sortie lorsque l’appel LLM se termine avec une erreur. |

| 5 | string | Le message de l'erreur |

Utilisation

Studio

Rechercher

Rechercher